豆包大模型团队开源 VideoWorld,无需语言模型实现视频生成

VideoWorld 模型开源

2 月 10 日消息,豆包大模型团队联合北京交通大学和中国科学技术大学共同开发的视频生成实验模型 “VideoWorld” 今日正式开源。与 Sora、DALL-E、Midjourney 等主流多模态模型不同,VideoWorld 在业界首次实现无需依赖语言模型即可认知世界。

纯视觉信号学习

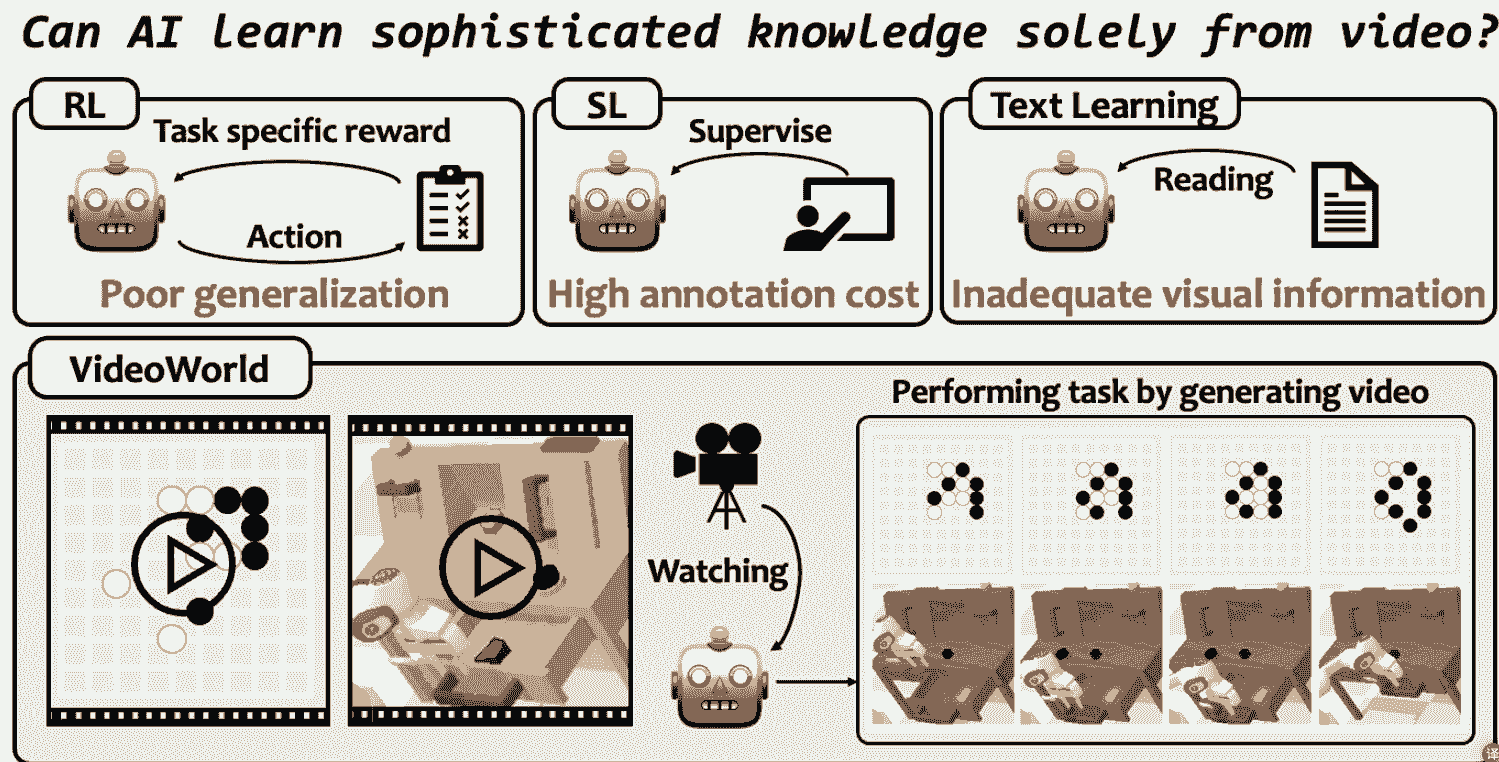

现有模型大多依赖语言或标签数据学习知识,很少涉及纯视觉信号的学习。然而,语言并不能捕捉真实世界中的所有知识。例如,像折纸、打领结等复杂任务,难以通过语言清晰表达。而 VideoWorld 去掉语言模型,实现了统一执行理解和推理任务,使得模型更加贴近实际应用场景。

高效压缩与多任务执行

VideoWorld 基于一种潜在动态模型,可高效压缩视频帧间的变化信息,显著提升知识学习效率和效果。在不依赖任何强化学习搜索或奖励函数机制的前提下,VideoWorld 达到了专业 5 段 9x9 围棋水平,并能够在多种环境中执行机器人任务,展现了其强大的多任务处理能力。

相关资源链接

有关 VideoWorld 的更多信息和资源,附上以下链接:

- 论文链接:arXiv

- 代码链接:GitHub

- 项目主页:VideoWorld

结论

豆包大模型团队此次开源的 VideoWorld 模型,通过去掉语言模型,实现了纯视觉信号的学习和认知,填补了现有多模态模型的空白。其高效压缩视频帧间变化信息的能力,以及在多任务环境中的出色表现,展示了其巨大的应用潜力。随着 VideoWorld 的开源,研究人员和开发者可以进一步探索其在各类实际场景中的应用,推动视频生成技术的发展和进步。